在本文中,我们将探讨NVIDIA 集成 RISC-V 内核的战略举措、其对 AI 格局的影响以及对更广泛的HPC 生态系统的意义。

继续阅读

Google AI TPU

在本文中,我们将探讨NVIDIA 集成 RISC-V 内核的战略举措、其对 AI 格局的影响以及对更广泛的HPC 生态系统的意义。

继续阅读

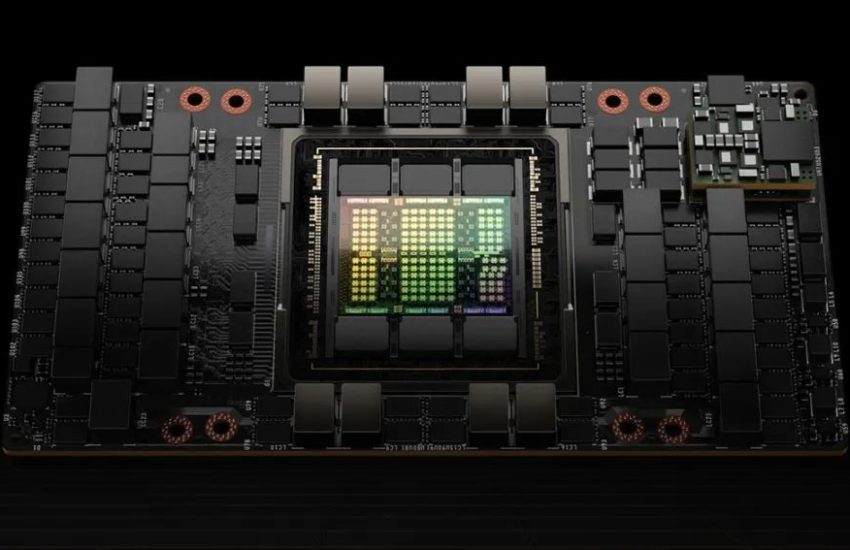

在人工智能领域,英伟达作为行业领军者,推出了两种主要的GPU版本供AI服务器选择——NVLink版(实为SXM版)与PCIe版。

继续阅读

2024年,数据中心市场,英伟达显卡依然一卡难求,已发布的A100、H100,L40S,还有即将发布的H200都是市场上的香饽饽。

继续阅读

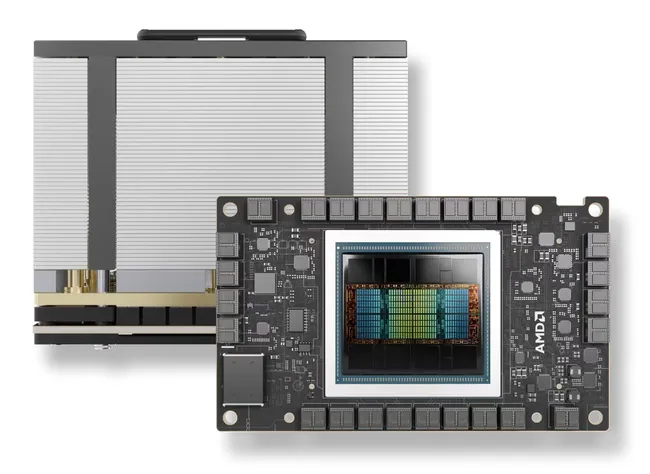

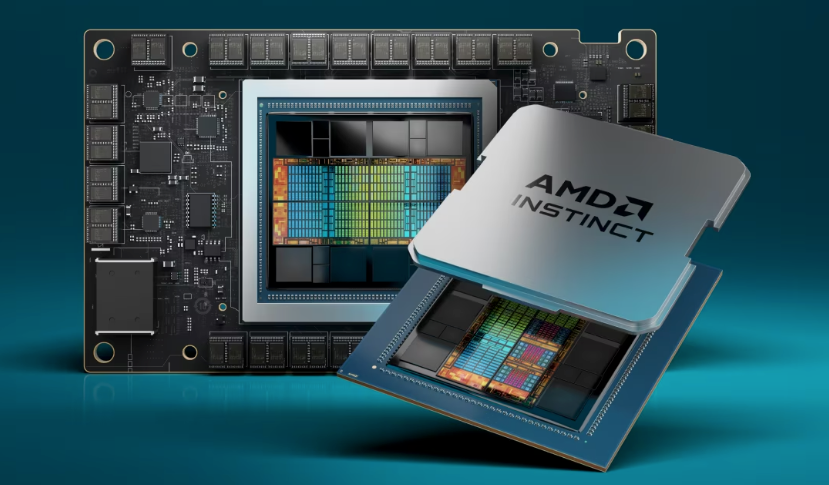

AMD于今年 12 月初发布了MI300X 图形加速器,声称比 Nvidia 的 H100 领先 1.6 倍。

继续阅读

加速深度学习模型的训练和推理过程对于充分发挥其潜力至关重要,而NVIDIA GPU在这方面已经成为改变游戏规则的技术。

继续阅读

AMD 今天宣布推出期待已久的 MI300X 加速器芯片,AMD 打算成为 NVIDIA 旗舰 H100 GPU 的有力竞争对手。

继续阅读

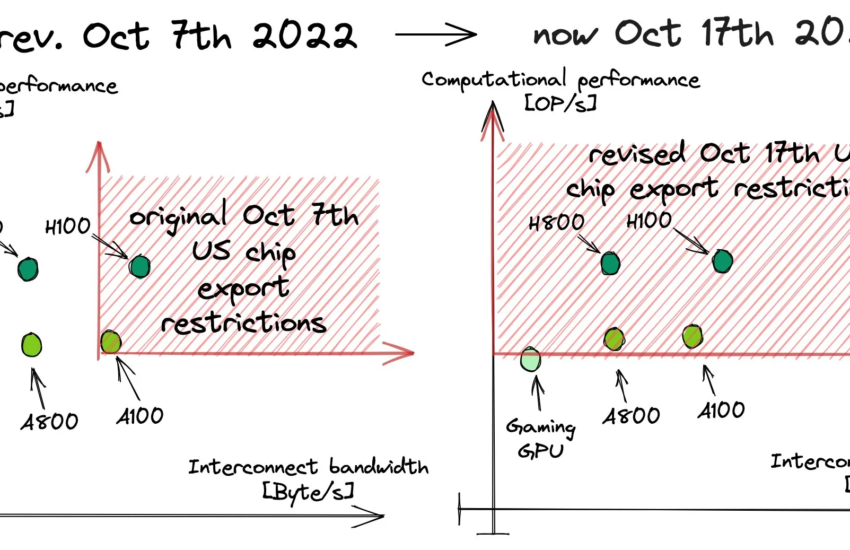

美国政府对21世纪的“冷战”发动了最新的回击,涵盖了AI芯片和晶圆制造设备。

继续阅读

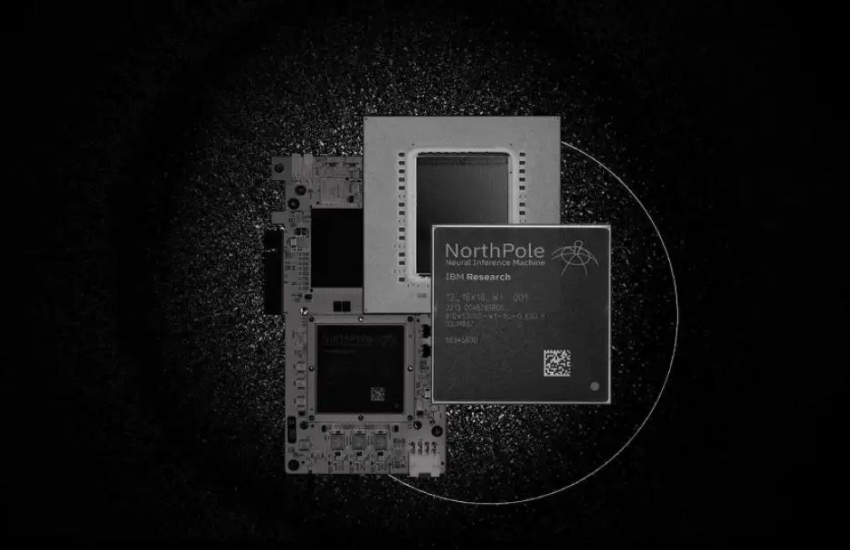

IBM的“北极”NorthPole是一种类脑芯片,我们需要先了解什么是类脑芯片。

继续阅读

随着人工智能和图形处理需求的不断增长,多 GPU 并行计算已成为一种趋势。

继续阅读

Nvidia发布了一份财务报告,其中包含新的Nvidia芯片路线图,囊括了GPU、GPU以及交换ASIC芯片。

继续阅读