在人工智能领域,英伟达作为行业领军者,推出了两种主要的GPU版本供AI服务器选择——NVLink版(实为SXM版)与PCIe版。

继续阅读

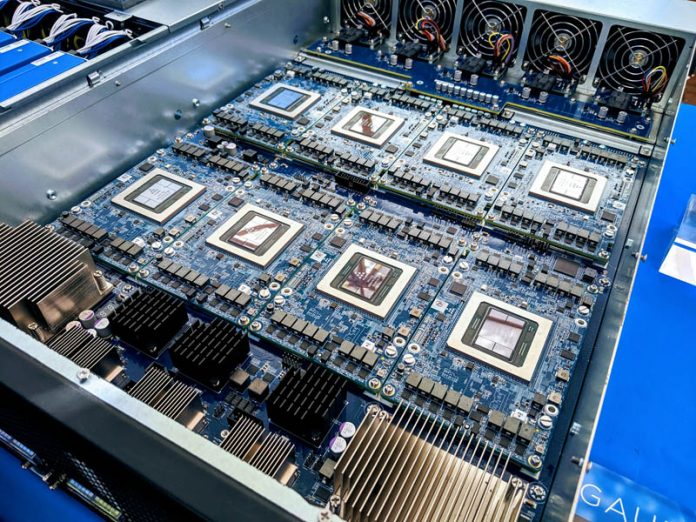

Google AI TPU

在人工智能领域,英伟达作为行业领军者,推出了两种主要的GPU版本供AI服务器选择——NVLink版(实为SXM版)与PCIe版。

继续阅读

AI 时代 GPU 成为核心处理器,分布式训练诉求提升。GPU 采用并行计算方式,擅长处理大量、简单的运算,因此多适用于图像图形处理和 AI 推理。

继续阅读

在单个GPU性能有限的情况下,将两个或多个GPU连接起来这种在当时看起来非常荒谬的想法竟然渐渐成为提升系统GPU性能的主流方法。

继续阅读

随着人工智能和图形处理需求的不断增长,多 GPU 并行计算已成为一种趋势。

继续阅读

NVLink的目标是突破PCIe接口的带宽瓶颈,提高GPU之间交换数据的效率。2016年发布的P100搭载了第一代NVLink,提供160GB/s的带宽,相当于当时PCIe 3.0 x16带宽的5倍。

继续阅读

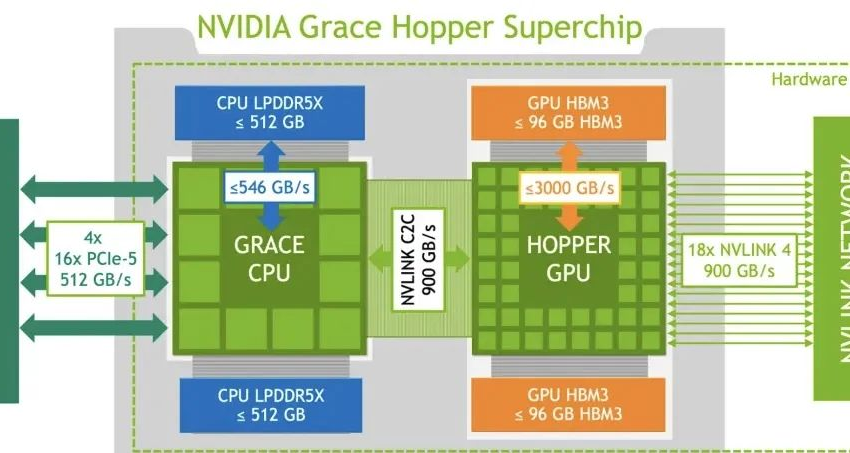

前些天,英伟达发布了号称最强AIGC芯片:GH200 Grace Hopper超级芯片,相比H100而言,GH200究竟强在哪?

继续阅读

12月3日消息,亚马逊(Amazon)云计算业务部门AWS与英特尔官网的信息显示,亚马逊弹性计算云(EC2)实例将采用英特尔旗下Habana Labs的Gaudi加速器。

继续阅读

前几天,NVIDIA A100 GPU已从40GB升级至80GB,今天,我们已经得到了其主要(当前)竞争对手AMD对NVIDIA A100 GPU的回应:Instinct MI100 32GB CDNA GPU。

继续阅读