加速深度学习模型的训练和推理过程对于充分发挥其潜力至关重要,而NVIDIA GPU在这方面已经成为改变游戏规则的技术。

在本文中,我们关注NVIDIA最新的L40S GPU(可立即供货)并将其与NVIDIA A100 GPU进行比较。由于A100的交货时间从30-52周不等,许多客户正在将L40S视为可行的替代品。

性能

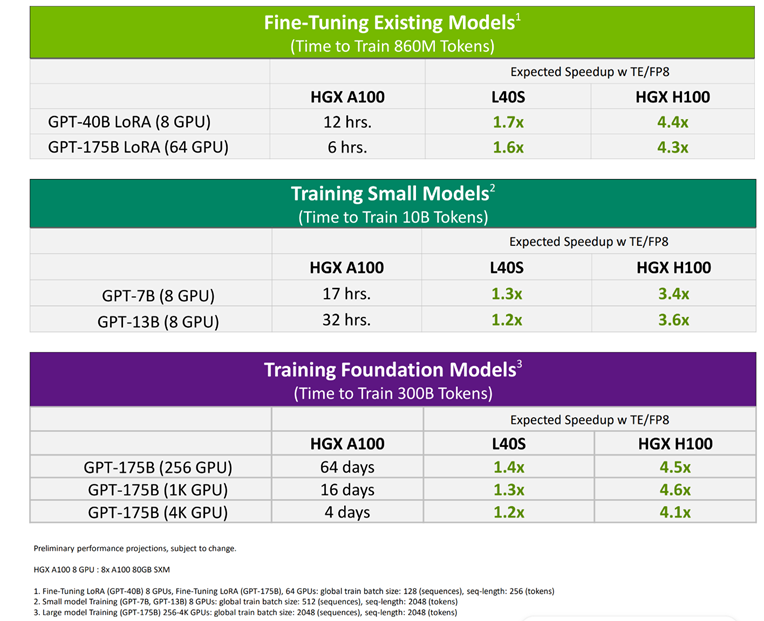

L40S可以加速AI训练和推理工作负载,是微调、训练小型模型和小型/中型训练(最多4K GPU)的优秀解决方案。请参阅下面的图表,了解A100与L40S的性能估计。

更多的性能数据可供参考,如衡量性能、MLPerf基准测试。

内存大小和带宽

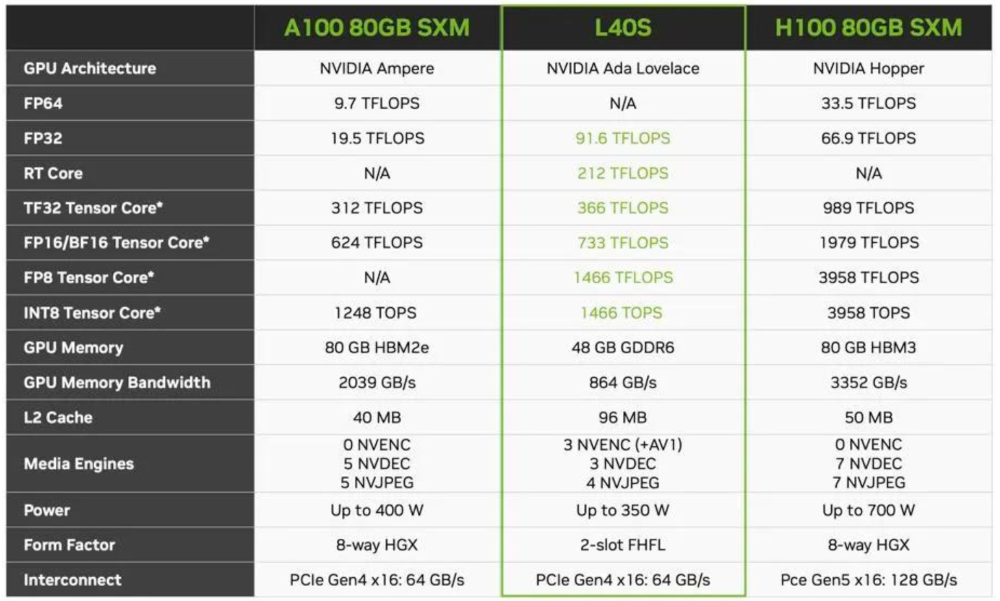

在选择GPU时,需要考虑其内存和带宽能力,以确保满足特定LLM推理和训练工作负载的要求。确定数据集的大小、模型的复杂性和项目的规模,这些因素将指导我们选择能够确保顺畅和高效操作的GPU。

以下是L40S、A100和H100规格的比较:

最终,充分考虑工作负载需求和项目预算,对于做出关于适合LLM努力的适当GPU的明智决定至关重要。

成本和可用性

虽然NVIDIA A100是一款用于LLM工作负载的强大GPU,但其先进的技术带来了较高的价格。相比之下,L40S以实惠的价格提供了出色的性能和效率。

重要的是,L40S现可立即供货,而A100的交货时间则有所延长。考虑到L40S的性能和效率,许多客户认为它是极具吸引力的选择,无论对替代GPU的交货时间有何担忧。

为LLM推理和训练选择合适的GPU是直接影响模型性能和生产力的关键决策。NVIDIA L40S在性能和价格之间达到了良好的平衡,使其成为优秀选择。