12月3日消息,亚马逊(Amazon)云计算业务部门AWS与英特尔官网的信息显示,亚马逊弹性计算云(EC2)实例将采用英特尔旗下Habana Labs的Gaudi加速器。

今天(2020年12月3日),亚马逊云计算业务CEO安迪·加西(Andy Jassy)宣布了采用Intel Habana Gaudi培训卡的Amazon AWS EC2实例。我们跟踪Habana Labs已有一段时间了。事实证明,Habana是Facebook AI训练大赛的一部分,并且击败了Intel的Nervana芯片。在Habana赢得此次比赛后,英特尔收购了Habana Labs并激发了其在AI方面的努力,与此同时,关闭了Nervana训练卡。

Amazon Aws宣布基于英特尔Habana Gaudi的EC2实例

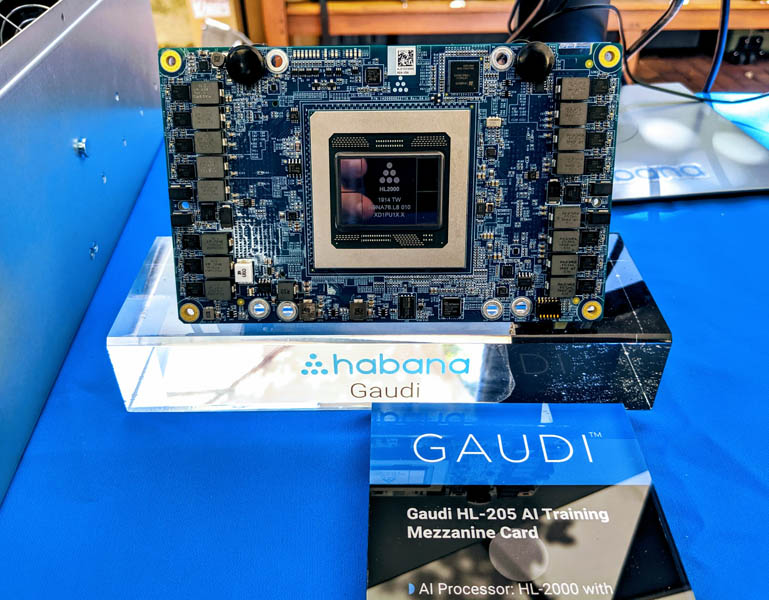

作为其AWS重塑2020大会主题演讲的一部分,公司宣布“在2021年上半年”将有一种新的AI Training加速器推向云端。通常,一年的“上半年”被市场翻译成第二季度。这是一件大事,因为它是除了Facebook外的另一家主要的云提供商签署了加入了Habana平台。 尽管亚马逊没有透露公司使用的是哪个版本的高迪(Gaudi),但英特尔的新闻图片是Open Compute Project OAM/OAI版本。不采用印刷效果图,下面让我们看看英特尔Habana Gaudi HL205 OAM卡。

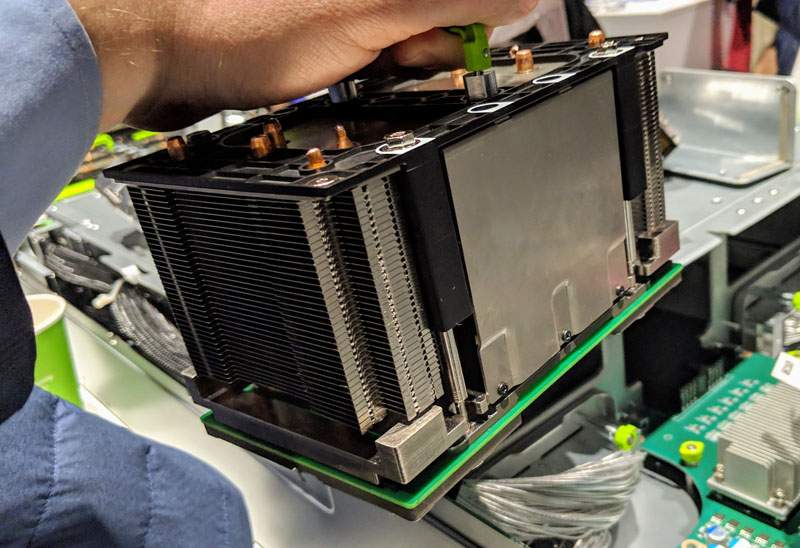

OAM模块的散热设计是在设备顶部进行大量的冷却。下面是Facebook Zion系统的OAM散热(空气)板,我们在2019年OCP峰会上看到过。当时我们介绍了Facebook OCP加速器模块OAM。

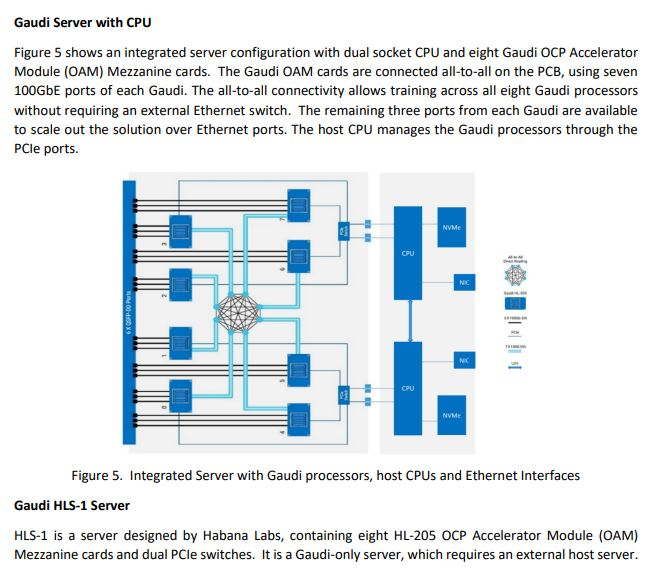

OAM架构的关键是大量的高速和高密度I/O。高迪(Gaudi)将其用于主机互联和提供高速RoCEv2以太网互联。对于云供应商,我们听说业界更倾向于选择使用100GbE,因为与使用Infiniband相比,它更易于集成到基础架构中。

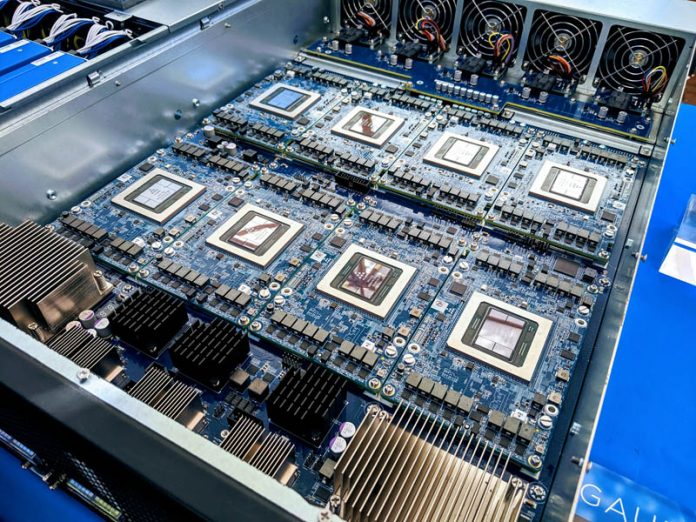

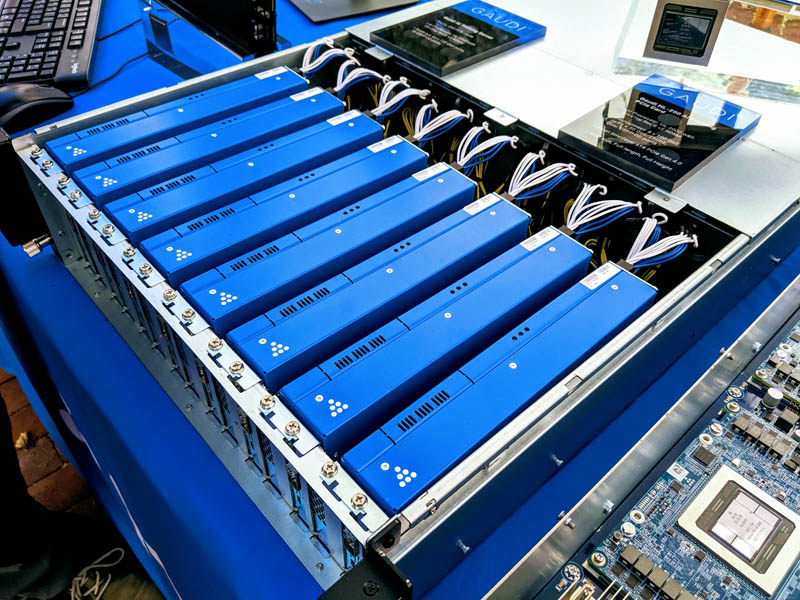

本文的封面图片就是一个8x GPU OAM的服务器。

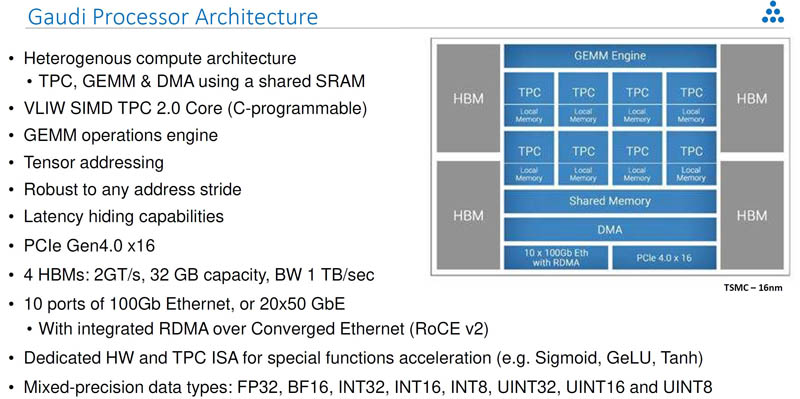

关于高迪,下面是一个上层的视图。正如我们想从在2021年中期的解决方案中期望的那样,这是另一个带有HBM的PCIe Gen4架构。每个Gaudi处理器具有10个100GbE端口或20个50GbE的端口,用于1Tbps的以太网带宽。

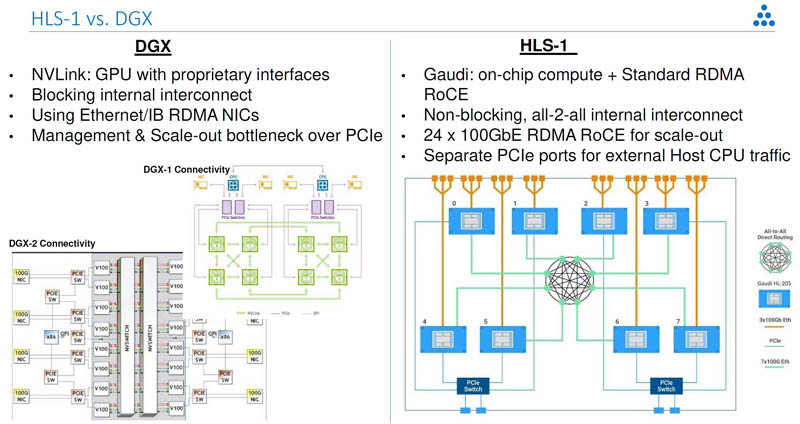

英特尔Habana在使用Gaudi AI加速器的HLS-1上展示的最大优势之一是,它没有将NVLink与专有的NVSwitches一起使用。相反,它使用的是商品化的互连。

根据英特尔和AWS一起发布的公告,EC2 Habana实例很可能是基于OAM,还有Gaudi HL-2000 PCIe卡。

从我们在2019年的Hot Chips上看到,这些PCIe卡已经在服务器中使用一年多了。

英特尔一直没有公开发布其Habana的产品组合,但是,与在第一季度末/第二季度初发布Ice Lake Xeon的同时发布这些类型的PCIe Gen4人工智能训练卡是非常有意义的。

小结

行业的整体竞争良好,我们看到具有32GB Gaudi训练芯片的Intel Habana。AMD Instinct MI100也具有32GB。NVIDIA刚刚发布了NVIDIA A100 80GB。还有其他一些诸如Graphcore GC200 IPU等专注于类似领域的产品。良性的竞争给行业的进一步发展提供了非常好的动力。期望看到这些厂家有更多更好的产品发布。