加速深度学习模型的训练和推理过程对于充分发挥其潜力至关重要,而NVIDIA GPU在这方面已经成为改变游戏规则的技术。

继续阅读

Google AI TPU

加速深度学习模型的训练和推理过程对于充分发挥其潜力至关重要,而NVIDIA GPU在这方面已经成为改变游戏规则的技术。

继续阅读

我认为下一波数据平台就像一个操作系统。它不再只是一个数据分析机器。它是一个在新硬件顶部提供基础设施层的平台,使非技术企业和云提供商能够轻松利用这些新的人工智能能力。

继续阅读

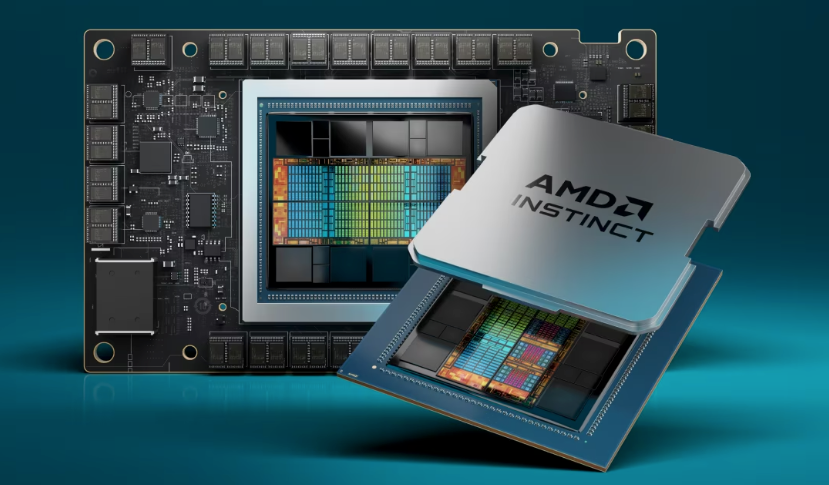

HBM全称为High Bandwidth Memory,直接翻译即是高带宽内存,是一款新型的CPU/GPU内存芯片。

继续阅读

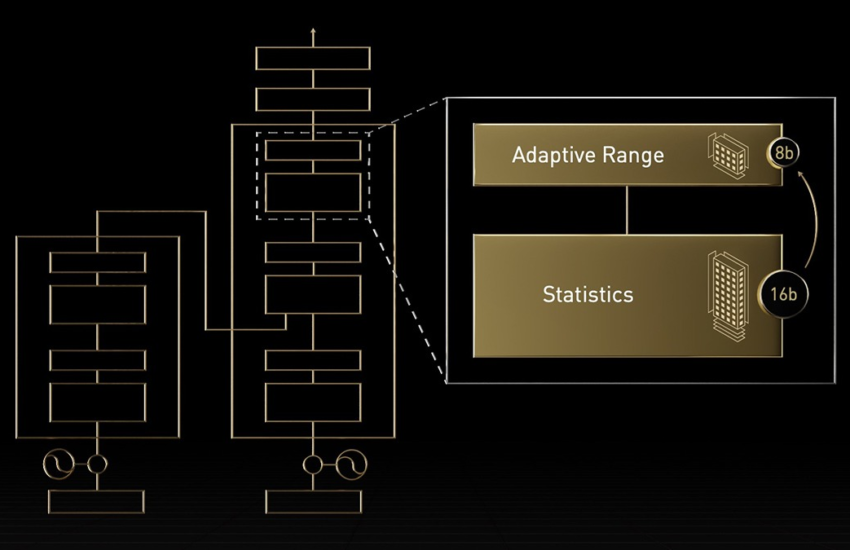

AMD 今天宣布推出期待已久的 MI300X 加速器芯片,AMD 打算成为 NVIDIA 旗舰 H100 GPU 的有力竞争对手。

继续阅读

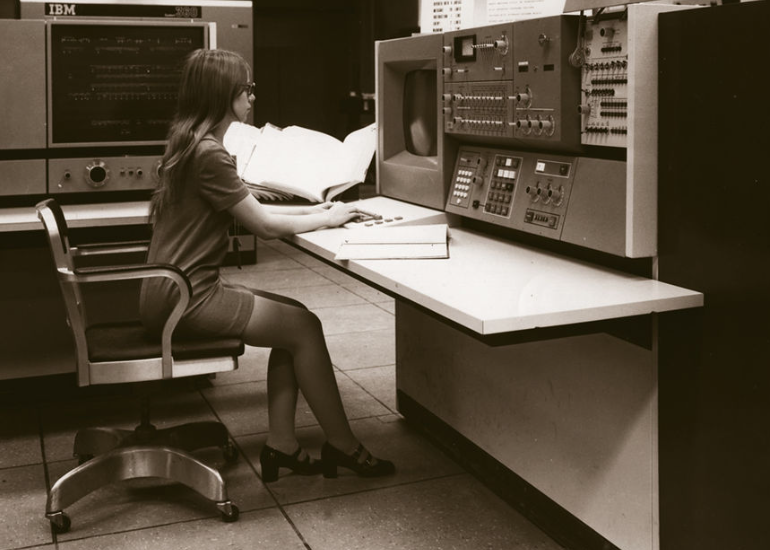

关于CPU缓存的由来,最早是在1964年IBM公司推出的一款大型老古董计算机–360/85中首次使用,就是下图这个大家伙。

继续阅读

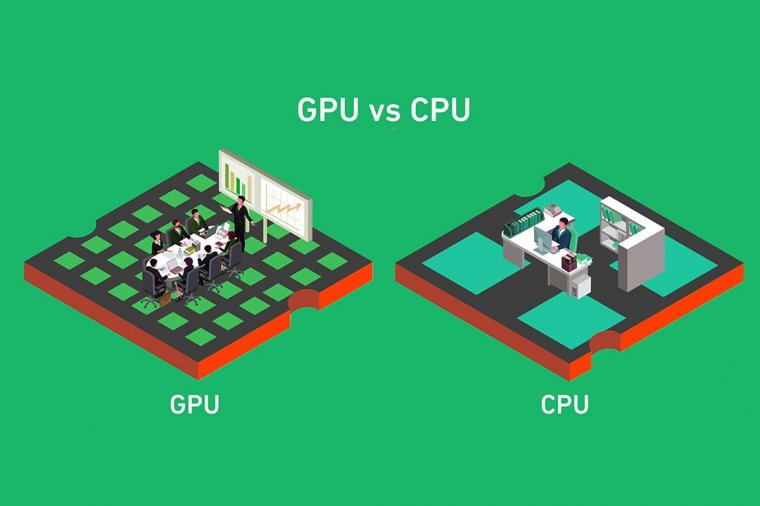

AI 时代 GPU 成为核心处理器,分布式训练诉求提升。GPU 采用并行计算方式,擅长处理大量、简单的运算,因此多适用于图像图形处理和 AI 推理。

继续阅读

OpenAI公司的ChatGPT在短短一个月内快速风靡全球,人工智能的快速发展,离不开高性能、高算力的硬件支持。

继续阅读

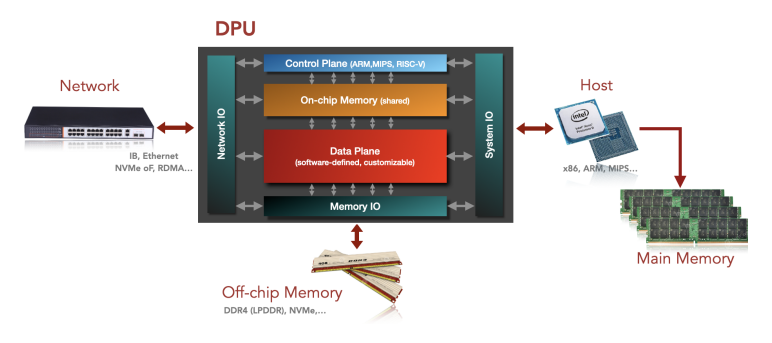

DPU 最直接的作用是作为 CPU 的卸载引擎,接管网络虚拟化、硬件资源池化等基础设施层服务,释放 CPU 的算力到上层应用。

继续阅读

CUDA是一个崭新的硬件和编程模型,它直接答复了这些问题并且展示了GPU 如何成 为一个真正的通用并行数据计算设备。

继续阅读