12月3日消息,亚马逊(Amazon)云计算业务部门AWS与英特尔官网的信息显示,亚马逊弹性计算云(EC2)实例将采用英特尔旗下Habana Labs的Gaudi加速器。

继续阅读

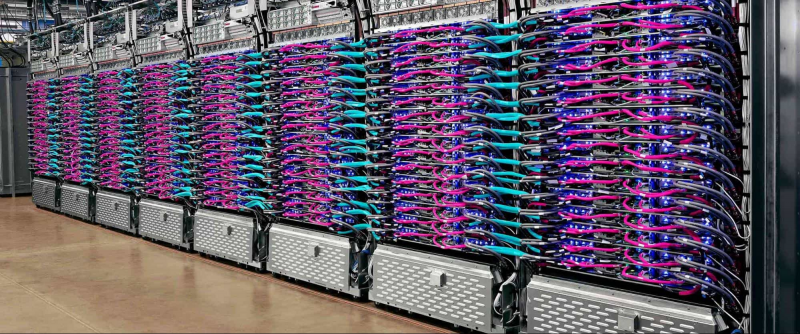

Google AI TPU

随着时代快速发展的人工智能,已然成为引领新一轮科技革命和产业变革的核心驱动力,并全面深刻地改变着人类的生产和生活方式。

12月3日消息,亚马逊(Amazon)云计算业务部门AWS与英特尔官网的信息显示,亚马逊弹性计算云(EC2)实例将采用英特尔旗下Habana Labs的Gaudi加速器。

继续阅读

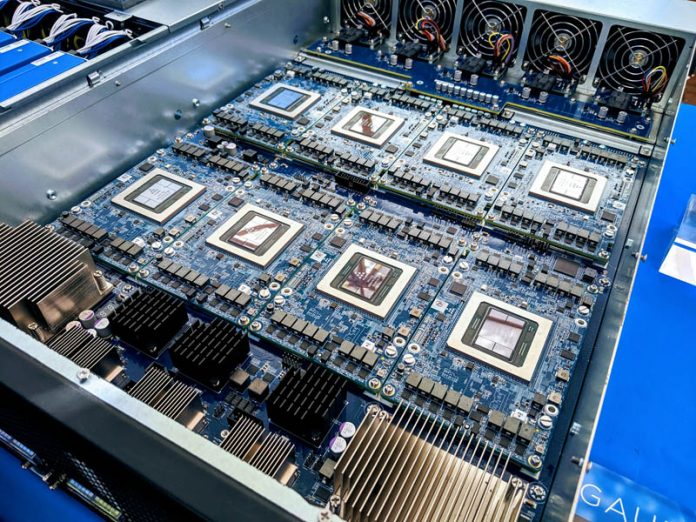

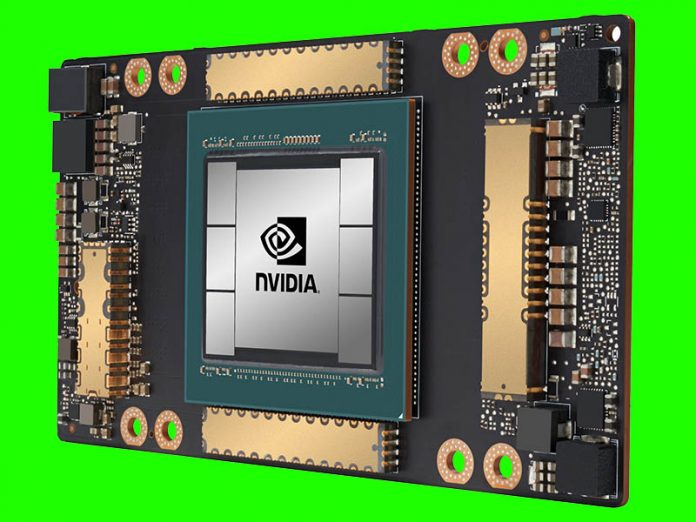

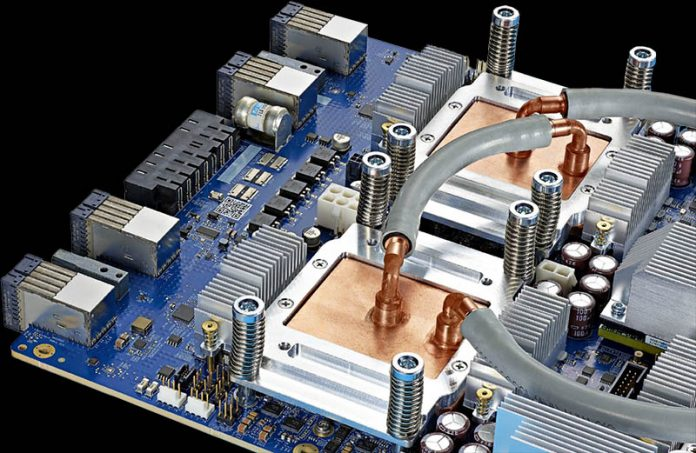

新的NVIDIA A100 80GB将NVIDIA A100的内存容量增加了一倍,这儿,80GB的容量将使我们获得5个16GB HBMe栈。NVIDIA表示,由于产量原因,他们并没有使用你在下图中看到的第六点。

继续阅读

NVIDIA DGX A100成为顶级GPU计算解决方案已有几个月了,在这一代中,NVIDIA的8块GPU的解决方案从2

继续阅读

前几天,NVIDIA A100 GPU已从40GB升级至80GB,今天,我们已经得到了其主要(当前)竞争对手AMD对NVIDIA A100 GPU的回应:Instinct MI100 32GB CDNA GPU。

继续阅读

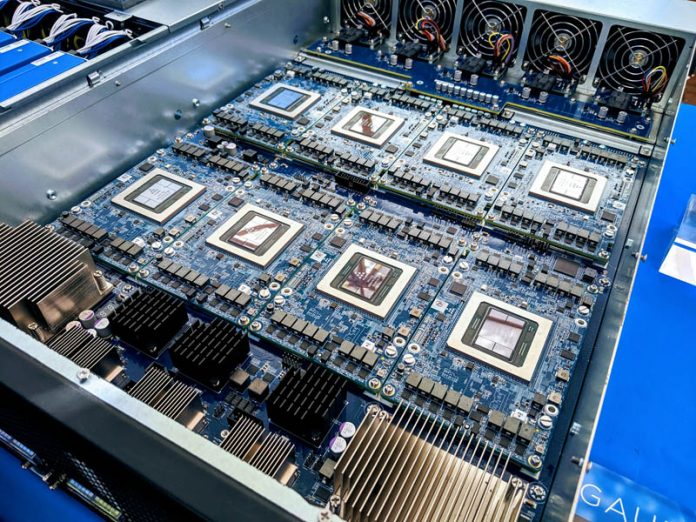

Gigabyte(技嘉)E251-U70是专为零售和电信机架设计的短深度2U服务器。

继续阅读

Google是AI训练的主要力量,设计了自己的加速芯片和系统,既可以用于内部目的,也可以通过Google Cloud平台租用给外部客户使用。

继续阅读

Google长期以来一直在开发自己的用于机器学习的加速器:早在2017年,我们描述了首批能够快速进行256×256矩阵乘法的TPU模型。

继续阅读