HDD的每TB带宽一直在下降。这迫使数据中心工程师通过将热(频繁访问的)数据转移到TLC闪存层或过度配置存储来满足其存储性能需求。

继续阅读

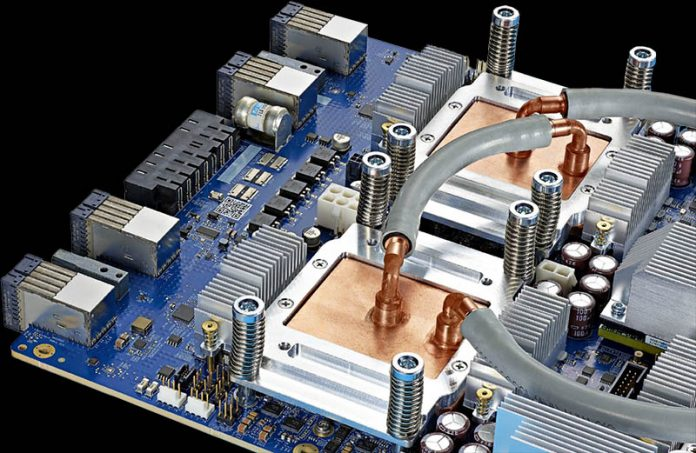

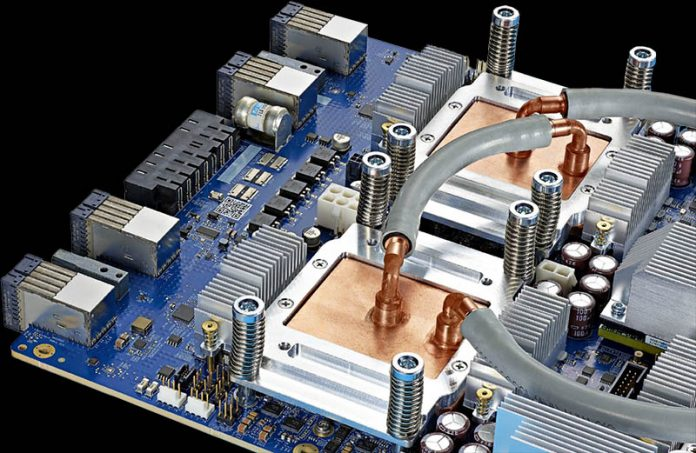

Google TPU v3在Hot Chips 32(2020)上的讨论

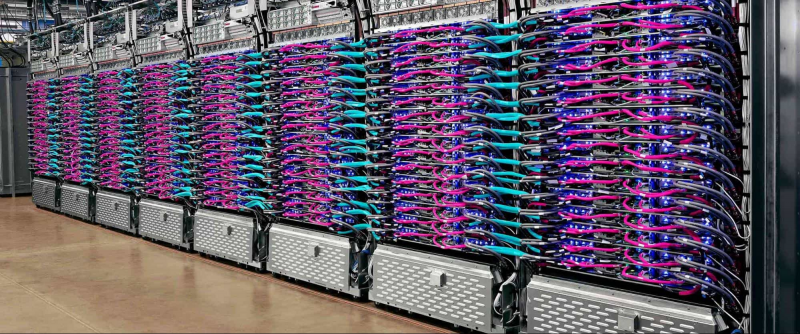

Google是AI训练的主要力量,设计了自己的加速芯片和系统,既可以用于内部目的,也可以通过Google Cloud平台租用给外部客户使用。

继续阅读Google AI TPU

Google是AI训练的主要力量,设计了自己的加速芯片和系统,既可以用于内部目的,也可以通过Google Cloud平台租用给外部客户使用。

继续阅读

Google长期以来一直在开发自己的用于机器学习的加速器:早在2017年,我们描述了首批能够快速进行256×256矩阵乘法的TPU模型。

继续阅读