大多数关于AI基础设施的讨论都从计算设备开始,然后结束。这些硬件包括用于训练复杂算法和基于这些模型进行预测的GPU、通用CPU、FPGA和张量处理单元(TPU)。但AI也对存储提出了很高的要求。保持强大的计算引擎充分利用需要尽可能快地提供大量信息。如果不足,将堵塞系统并造成瓶颈。

为了优化AI解决方案的容量和成本,同时满足增长需求,需要重新审视其数据管道。是否准备好摄取PB级别的历史数据、物联网数据和传感器数据?服务器是否具备数据准备所需的读写带宽?是否准备好进行训练所涉及的随机访问模式?

回答这些问题有助于确定企业是否准备好迎接AI。让我们分解AI工作负载的各个阶段,并解释数据管道在其中的作用。

关键要点

- 在整个AI工作流程中,数据的量级、速度和多样性在不同阶段都会发生变化。

- 构建一个能够满足工作流程容量和性能需求的存储基础设施是一项具有挑战性的任务。

- 为了有效扩展,应依赖现代接口(如NVMe)、闪存以及其它非易失性存储技术和分散架构。

从海量数据启程,走向精准预测

AI受到数据的驱动,而这些数据量庞大。平均工厂每天产生1TB的数据,但只分析和利用其中不到1%。因此,AI基础设施必须被设计成能够处理大量数据,即使并不是所有数据都用于训练神经网络。“数据集可以以PB的形式进入管道,以结构化和半结构化数据的几十GB的形式进入训练,最终以几KB大小的训练模型完成其旅程,”Intel存储营销经理Roger Corell指出。

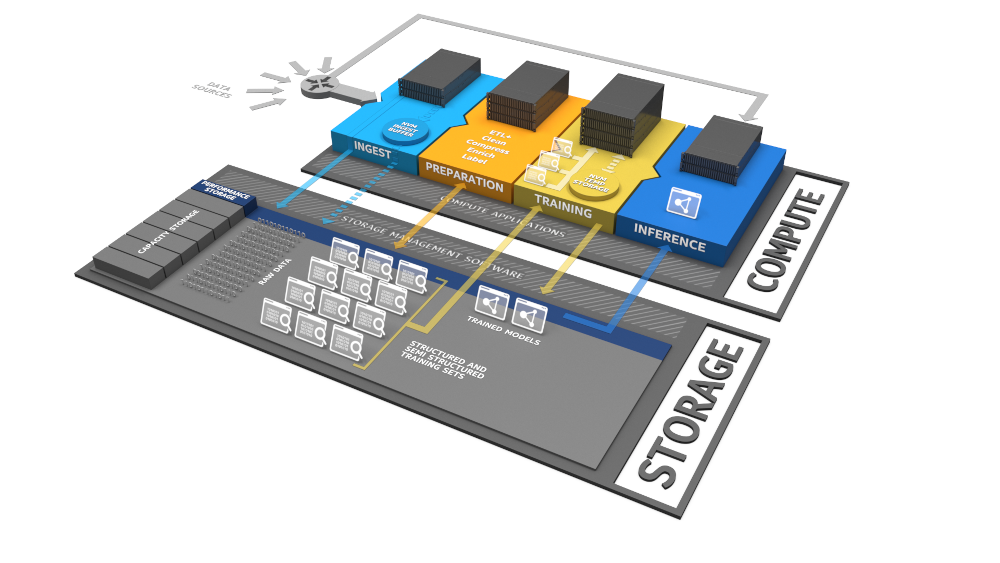

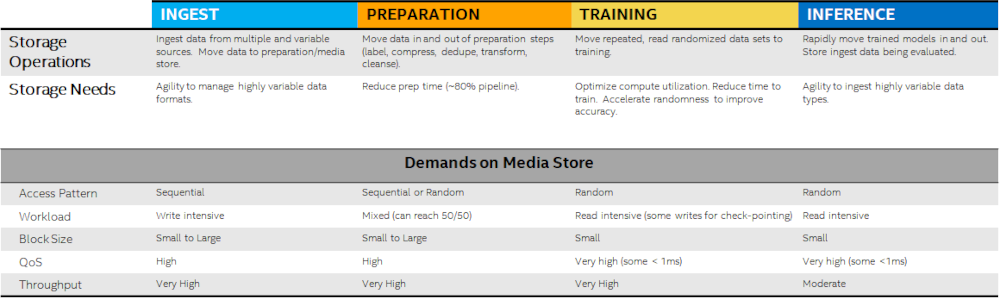

第一阶段是AI工作负载的摄取,涉及从各种来源(通常在边缘)收集数据。有时,这些信息被拉到中央高容量数据湖进行准备。或者它可能被路由到高性能存储层,以进行实时分析。无论哪种方式,这项任务都以大量大文件和小文件的顺序写入为特点。

接下来的步骤是数据准备,涉及以使其对后续阶段有用的方式处理和格式化原始信息。最大化数据质量是准备阶段的主要目的。容量仍然很关键。但工作负载会逐渐演变成随机读写的混合,因此I/O性能也成为一个重要考虑因素。

结构化数据然后被输入到神经网络中,用于创建训练模型。训练数据集可能包含数百万个示例,用于让模型学习识别特定物体。这个过程是迭代的。模型可以经过测试以提高准确性,然后重新训练以提高性能。一旦神经网络被训练,它就可以被部署用于根据以前从未见过的数据进行预测,这个过程被称为推理。

训练和推理是需要大规模并行处理器的计算密集型任务。保持这些资源充分供应需要从存储中读取小文件的数据流。访问延迟、响应时间、吞吐量和数据缓存都起到重要作用。

灵活满足AI在各个阶段的独特需求

在AI管道的每个阶段,存储基础设施都需要承担不同的任务。并没有一种适用于所有情况的固定模式可以保证成功,因此最好依靠具有适当性能的存储技术和接口,具备未来发展的路线图,并具备根据需求变化而进行扩展的能力。

例如,硬盘可能看起来是摄取阶段容量需求的廉价解决方案。但它们并不适合扩展性能或可靠性。即使是基于非易失性内存扩展(NVMe)接口的SATA固态硬盘也会受到存储接口的限制。而连接到PCIe总线的NVMe存储提供了更高的吞吐量和更低的延迟。

NVMe存储可以采用多种不同的形态。插卡是一种常见选择,2.5英寸盘也是常见的形式。然而,越来越多的情况下,企业和数据中心采用的SSD外形尺寸(EDSFF),使得构建用于高速闪存存储的密集型存储服务器成为可能。

在AI管道的其它节点上,采用连接到PCIe总线的存储是明智的选择。数据准备阶段需要高吞吐量、随机I/O和大容量,可以通过平衡成本和性能的全闪存阵列来满足这些需求。与此同时,训练和推理阶段需要低延迟和出色的随机I/O。因此,企业级闪存或Optane SSD将是保持计算资源充分利用的最佳选择。

与数据共同成长

为了满足当前的需求,构建的AI基础设施将随着数据量的增加和模型的复杂性不断演进。除了采用现代设备和协议外,正确的架构还有助于确保性能和容量能够同时扩展。

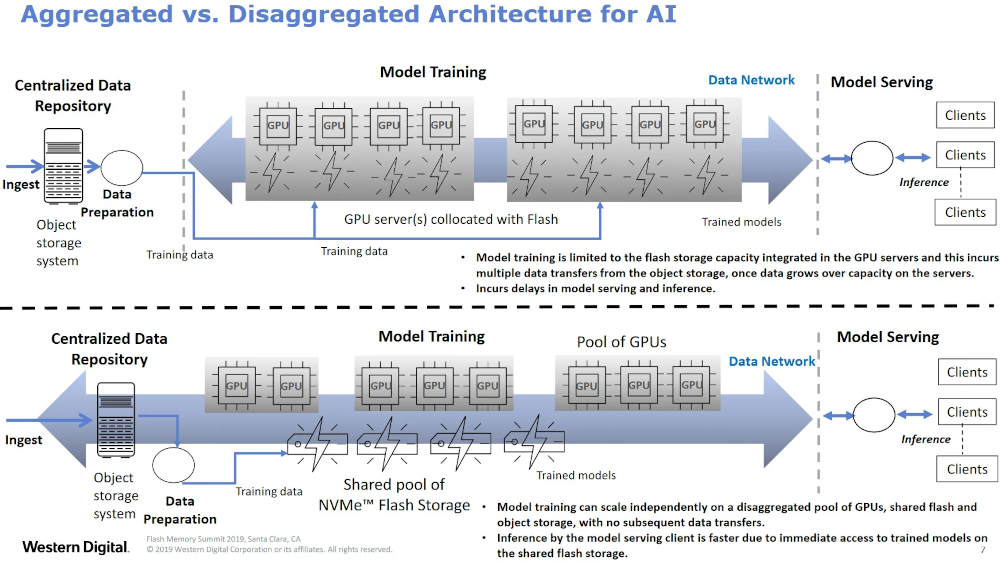

在传统的集成配置中,通常通过将带有自身闪存存储的计算服务器均匀地添加来实现扩展。这样的配置旨在避免由于使用机械硬盘和较老的接口而导致的性能瓶颈。然而,由于服务器受限于其自身的存储,当训练数据集超出本地存储容量时,就必须将数据传输到准备数据存储的位置。因此,这会导致更长的训练模型和启动推理的时间。

高效的协议,如NVMe,使得可以分离或分开存储,同时保持AI所需的低延迟。在存储开发者大会上,西部数据公司全球分析软件开发总监Sanhita Sarkar博士提供了多个关于为AI设计的分离数据管道的示例,其中包括GPU计算池、基于NVMe的闪存存储共享池以及用于源数据或存档的对象存储,所有这些都可以独立扩展。

时不我待,行动起来

如果还没有评估自己的AI准备情况,现在是迎头赶上的时候了。麦肯锡最新的全球调查显示,使用AI至少在一个流程或产品中的公司数量同比增长了25%。44%的受访者表示AI已经帮助降低了成本。“如果您是CIO,而您的组织没使用AI,那么很可能您的竞争对手正在使用,这应该是一个令人担忧的问题,”Gartner副总裁Chris Howard补充道。

对AI的投资也在加速增长。IDC表示,三年后,AI系统的支出将达到近980亿美元,而2019年为375亿美元。IDC的分析中还有另一个重要观察:“2019年技术支出的最大份额将用于服务,主要是IT服务,因为公司寻求外部专业知识来设计和实施他们的AI项目。”显然,需要熟悉AI管道复杂性的专业人员。

大多数企业都知道AI对计算资源要求很高。但对存储的技术需求并没有被广泛讨论。在设计自己的项目原型之前,了解一下存储基础设施的能力以及可能需要加强的地方。通过使用NVMe连接的现代硬盘,通过分散的架构进行扩展,应该能够很好地满足最依赖数据的应用程序的容量、性能和扩展需求。