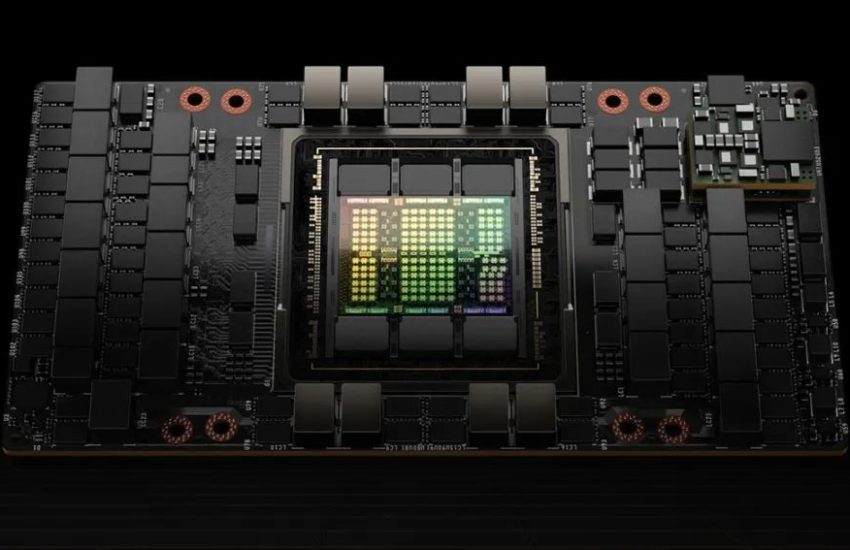

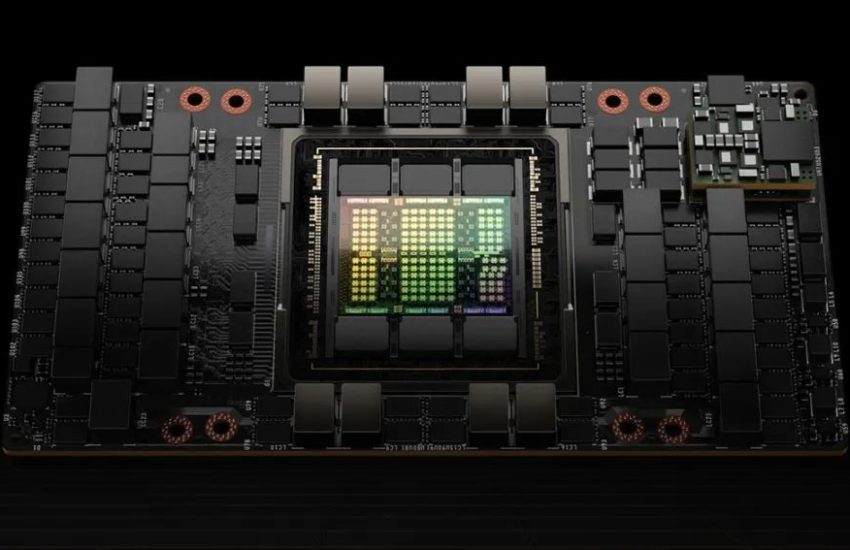

2024年,数据中心市场,英伟达显卡依然一卡难求,已发布的A100、H100,L40S,还有即将发布的H200都是市场上的香饽饽。

继续阅读

Google AI TPU

2024年,数据中心市场,英伟达显卡依然一卡难求,已发布的A100、H100,L40S,还有即将发布的H200都是市场上的香饽饽。

继续阅读

基于HBM3E,H200带宽可达4.8TB/s(比H100的3.35TB/s提升43%),并且内存容量从80GB提升至141GB,这使得H200成为高性能计算(HPC)和人工智能等领域的理想选择。

继续阅读